Top SEA- und Google Ads-Trends für 2026 – So bleibst du voraus!

2025 drehte sich SEA vor allem um datengetriebene Kampagnen, Zielgruppenansprache und Automatisierung. Tracking, strukturierte Daten und kreative Werb... mehr

Melina Sharghi

Melina Sharghi Wenn du möchtest, dass Google deine Website richtig versteht und optimal in den Suchergebnissen darstellt, brauchst du Meta Robots. Hinter dem Begriff verbirgt sich ein kleines, aber wirkungsvolles Werkzeug, mit dem du Suchmaschinen mitteilst, wie sie mit deinen Seiten umgehen sollen.

Das klingt zunächst technisch, ist aber einfacher, als viele denken. In diesem Artikel erfährst du, was es mit dem Meta Robots Tag auf sich hat, wie du ihn einsetzt und in welchen Fällen er besonders hilfreich ist.

Meta Robots sind spezielle Anweisungen, die im HTML-Code einer Seite eingebunden werden. Sie richten sich an sogenannte Crawler – also Programme wie dem Googlebot, der Webseiten automatisch durchsucht.

Mit einem Meta Robots Tag kannst du diesen Crawlern sagen, ob eine bestimmte Seite in den Suchindex aufgenommen werden soll oder nicht. Außerdem lässt sich damit steuern, ob Links auf der Seite verfolgt werden dürfen. Damit hast du direkten Einfluss darauf, wie deine Inhalte in den Suchergebnissen erscheinen – oder eben nicht erscheinen.

Es gibt eine Handvoll Meta Robots Befehle, die du kennen solltest:

Daneben gibt es noch zwei seltener verwendete Varianten:

Für die meisten Websites reichen jedoch die vier erstgenannten Befehle völlig aus.

Die Auswahl der richtigen Kombination hängt davon ab, welche Funktion eine Seite erfüllt.

Typische Anwendungsfälle für noindex sind zum Beispiel Login- oder Admin-Bereiche, Seiten, die sich noch in der Entwicklung befinden, oder Landingpages aus bezahlten Kampagnen (SEA), die du nicht doppelt im Google-Index haben möchtest. Auch URLs, die durch interne Suchfunktionen erzeugt werden, sollten meist nicht indexiert werden, da sie sonst unnötigen oder doppelten Content erzeugen könnten.

nofollow wird ebenfalls gern für nicht öffentliche oder interne Seiten verwendet, etwa in Admin-Bereichen. So verhinderst du, dass Suchmaschinen dort enthaltenen Links folgen, was wiederum die Crawl-Effizienz verbessert.

index und follow nutzt du für alle Seiten, die in den Suchergebnissen auftauchen und deren Inhalte gefunden werden sollen – also zum Beispiel deine wichtigsten Landingpages, Blogartikel oder Produktseiten.

Wer etwas tiefer in die Technik einsteigen möchte, kann auch mit dem sogenannten X-Robots-Tag arbeiten. Anders als der Meta Robots Tag wird dieser serverseitig gesetzt und eignet sich auch für die Steuerung von Nicht-HTML-Dateien wie PDFs oder Bildern.

Für den typischen Website-Betrieb ist der Einsatz des X-Robots-Tags aber in der Regel nicht notwendig. In den meisten Fällen reicht das klassische Meta Robots Tag vollkommen aus.

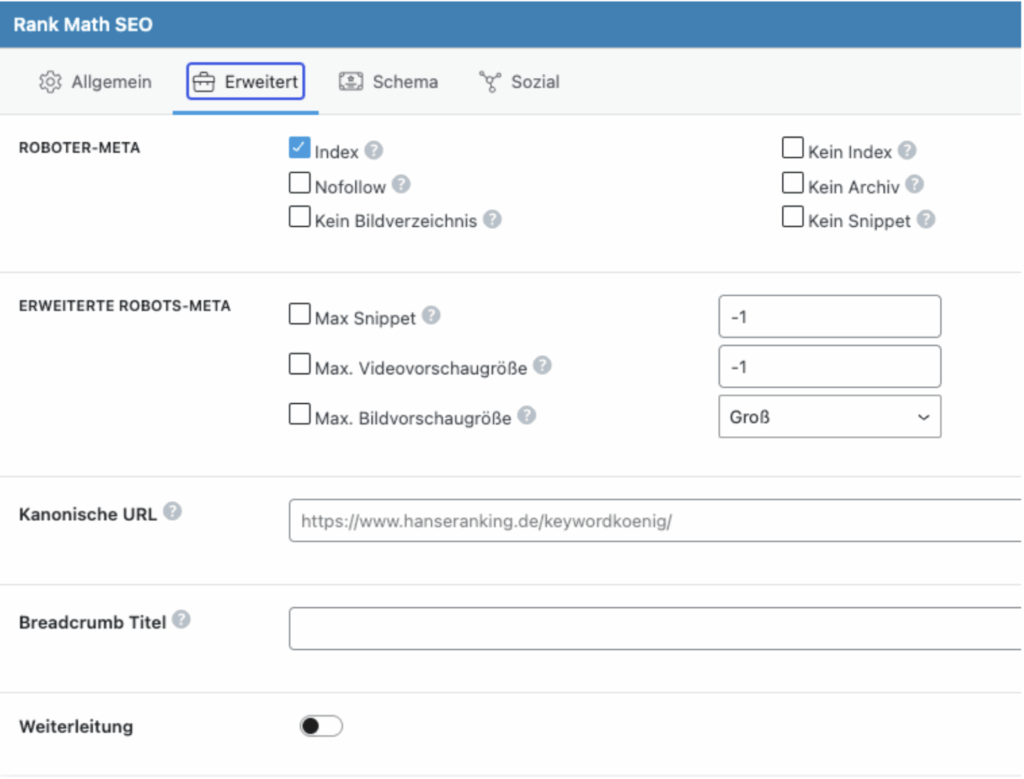

Falls du mit WordPress arbeitest, ist die Umsetzung besonders einfach. Viele SEO-Plugins wie Yoast SEO oder Rank Math bieten eine benutzerfreundliche Oberfläche, über die du Meta Robots Einstellungen direkt auf Seiten- oder Beitragsebene vornehmen kannst.

Du öffnest einfach den gewünschten Beitrag, scrollst ein Stück nach unten und findest dort die entsprechenden Optionen. Mit wenigen Klicks legst du fest, ob eine Seite indexiert werden darf und ob Links verfolgt werden sollen.

Meta Robots sind ein kleines, aber wirkungsvolles Mittel, um Suchmaschinen gezielt zu steuern. Du kannst damit sicherstellen, dass wirklich nur die Seiten im Google-Index landen, die dort auch hingehören, und gleichzeitig unnötigen oder doppelten Content vermeiden. Besonders in Kombination mit einem guten SEO Plugin lässt sich das ganz ohne Programmierkenntnisse umsetzen.

Wer die Funktionsweise einmal verstanden hat, kann die Sichtbarkeit seiner Website gezielt verbessern – und das mit nur wenigen Einstellungen.

Als SEO Managerin bringe ich mein Wissen ins SEO Team von Hanseranking ein. Mit dem Verfassen von Blogartikeln kann ich es weiter ausbauen und mit Euch teilen.